正式入職小米還不到10天,羅福莉的首篇論文,這就來了!

在這篇出自MiMo團隊(主打空間智能)的研究中,羅福莉作為團隊負責人擔任核心作者,小米智駕團隊首席科學家陳龍則作為項目負責人。

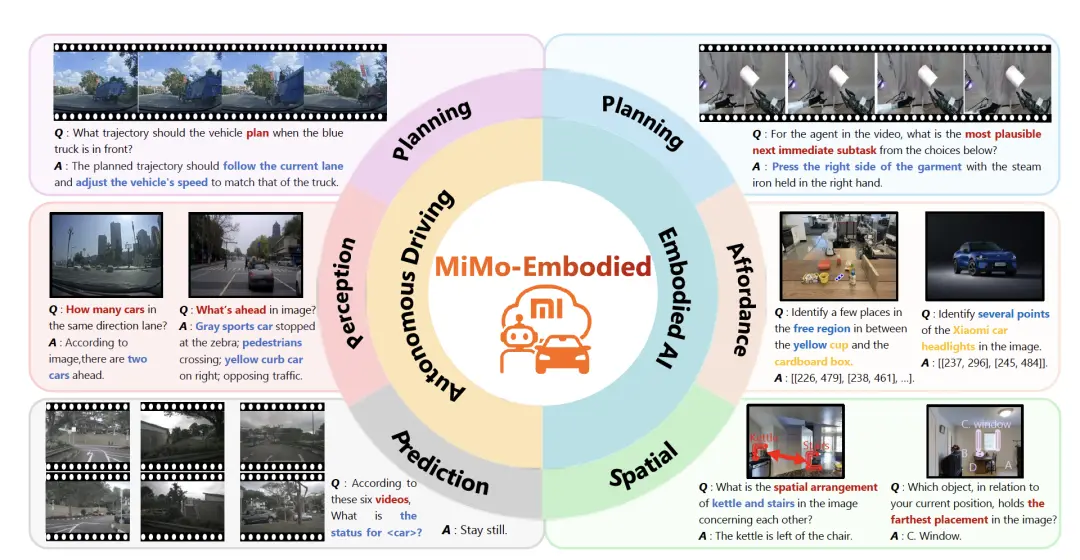

而這項研究最亮眼的地方,恰恰是具身智能與自動駕駛的跨界融合。

針對自駕與具身操作場景的知識遷移難題,MiMo團隊提出并開源了全球首個打通這兩大領域的跨具身(X - Embodied)基座模型——MiMo-Embodied。

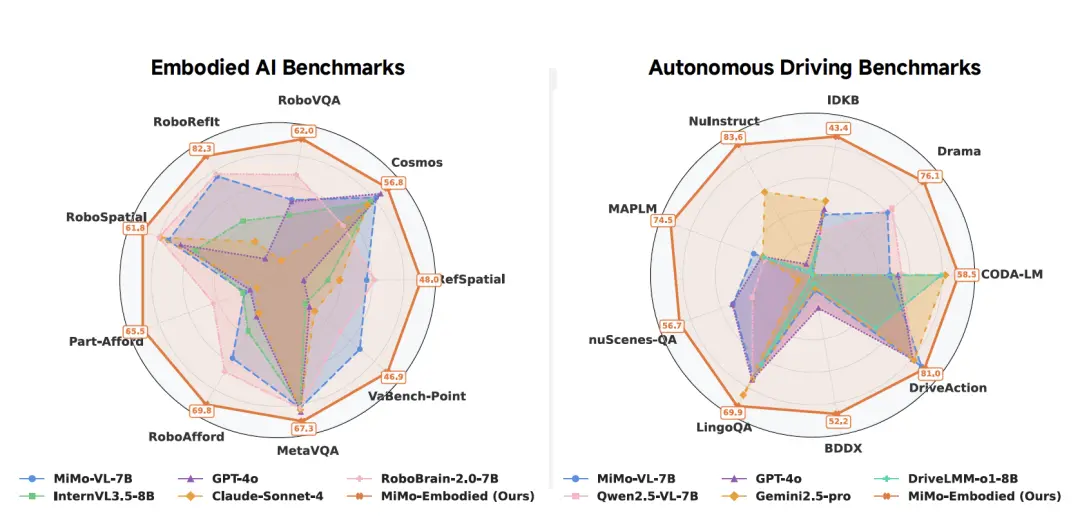

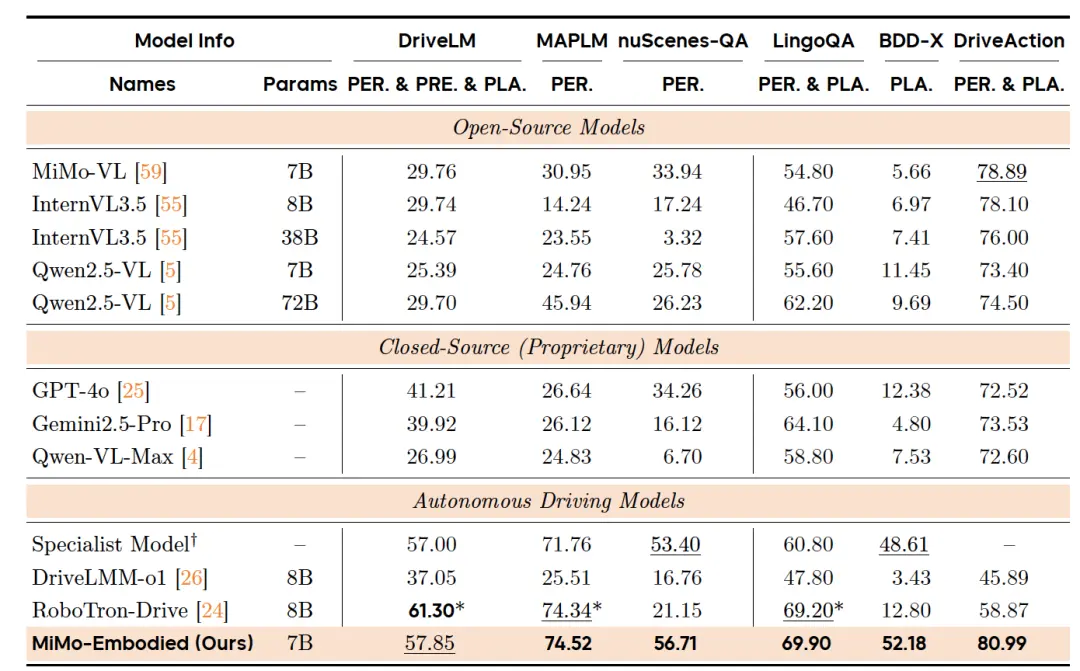

在實測效果上,MiMo-Embodied在自動駕駛與具身智能共計29個Benchmark上全部霸榜!

無論是開車的環境感知、規劃,還是機器人的拿取、導航,主打一個我全都要。

具身與智駕,小米全都要!

如上所說,小米這次開源的MiMo-Embodied是業界首個開源的、成功融合了自動駕駛與具身智能(Embodied AI)兩大領域的統一多模態基礎模型。

它基于MiMo-VL架構,通過構建涵蓋通用視覺、具身任務及駕駛場景的高質量數據集,并采用包含思維鏈(CoT)和強化學習(RL)的漸進式四階段訓練策略,有效打破了室內操作與戶外駕駛之間的領域鴻溝。

最終,該模型在任務規劃、空間理解、環境感知及駕駛規劃等29個基準測試中,均超越了現有的專用模型及通用模型,實現了跨領域的最先進(SOTA)性能。

接下來,我們具體來看。

在以往具身/自駕的VLM領域中,往往存在以下問題:

一方面是缺乏統一的具身VLM(Unified Embodied VLM)。

現有的視覺語言模型(VLMs)大多專注于單一領域(僅室內任務或僅戶外駕駛),缺乏能夠連接這兩個領域的統一模型。限制了模型在動態環境中與物理世界有效交互的能力。

而這,也帶來了領域差距與遷移困難。

具身智能側重于室內操作,而自動駕駛側重于戶外道路,兩者存在顯著的領域差距(Domain Gap),阻礙了能力的跨領域遷移 。

另一方面則是評估體系缺失, 即缺乏全面的跨具身能力評估體系來衡量模型在兩個領域的綜合表現。

為了解決這些挑戰, MiMo-Embodied試圖將自動駕駛和具身智能的任務合并到一個統一的VLM中,以整合模型的跨具身能力。

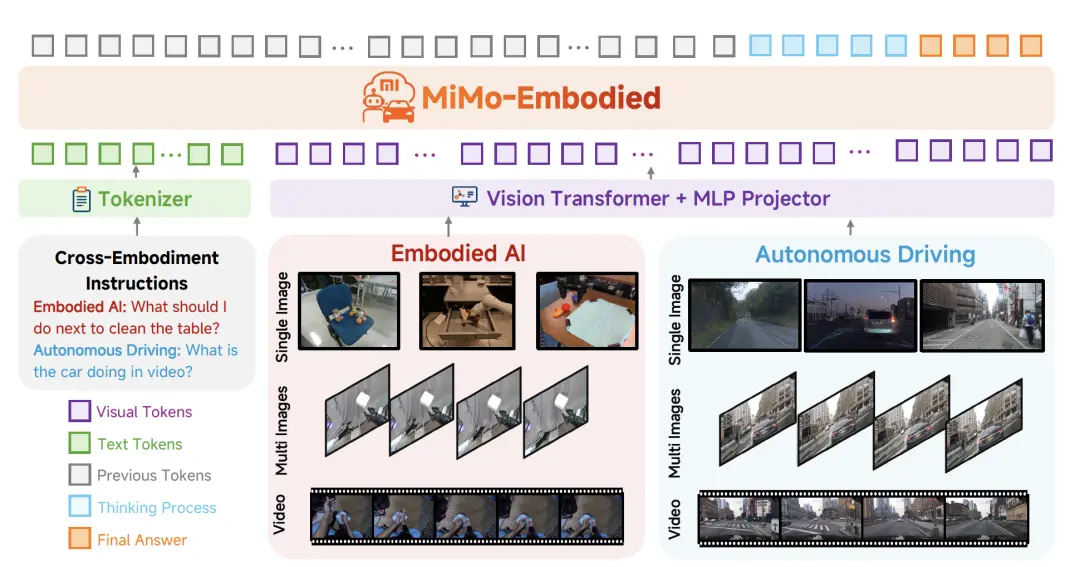

如上圖所示,MiMo-Embodied架構由以下三個部分組成:

用于編碼視覺輸入的 Vision Transformer (ViT):模型使用ViT來編碼各種類型的視覺輸入,包括單張圖像、多張圖像和視頻。這使得模型能夠提取復雜的模式和關系。

一個投影器(projector): 使用多層感知機(MLP)作為投影器(Projector),將視覺Token映射到與大語言模型對齊的潛在空間。

負責文本理解和推理的LLM:LLM作為核心組件,負責理解文本指令并結合視覺信息進行推理,生成連貫且上下文相關的響應。

由此,通過無縫集成視覺和文本領域,MiMo-Embodied增強了多樣化多模態推理任務和應用的潛力。

接下來,為了實現跨領域的統一能力,論文提出了一套系統的數據構建和分階段訓練策略:

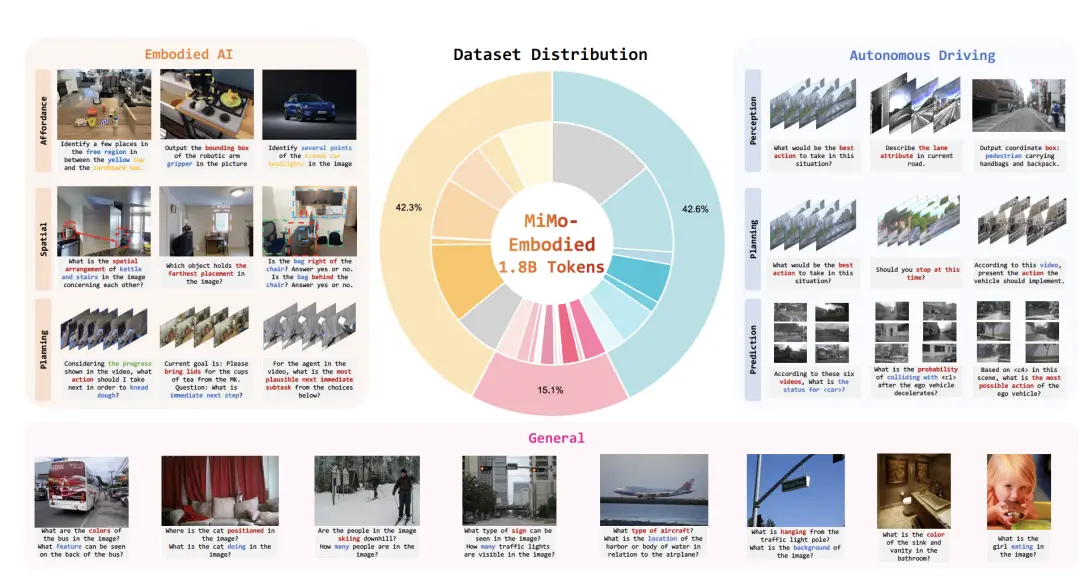

首先在數據方面,訓練數據涵蓋了通用多模態理解、具身 AI(功能性預測、規劃、空間理解)和自動駕駛(感知、預測、規劃)三個維度的多模態數據:

通用數據: 基于MiMo-VL語料庫,包含圖像、視頻、長文本等,長文檔和合成推理數據,確保廣泛覆蓋感知、推理和交互能力。

具身智能數據: 涵蓋可供性預測(Affordance Prediction)、高層任務規劃和空間理解,整合了如 PixMo-Points, RoboAfford, RoboRefIt等數據集。

自動駕駛數據: 涵蓋環境感知、狀態預測和駕駛規劃,整合了 CODA-LM, DriveLM, nuScenes-QA等數據集。

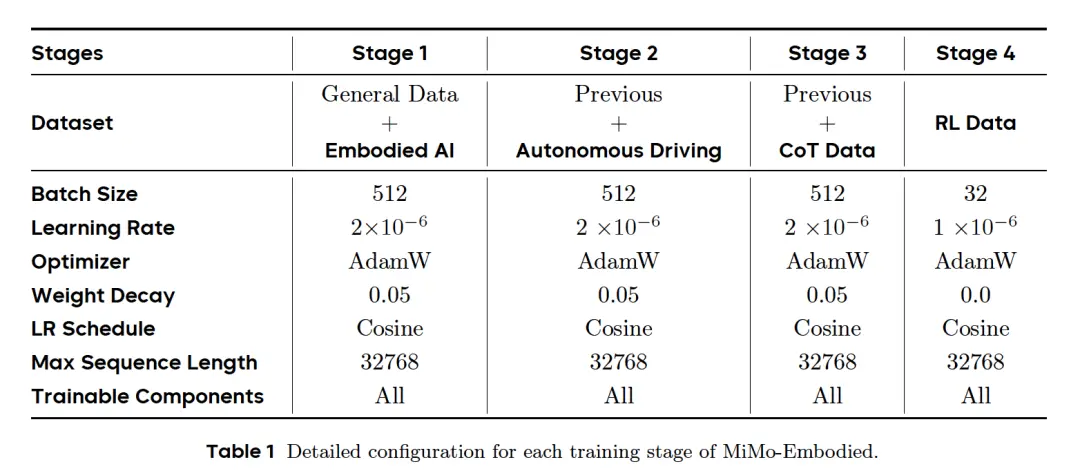

基于上述構建的數據集,研究又開發了一種四階段訓練策略。

基于MiMo-VL,研究引入了具身智能和自動駕駛方面的專門監督,最終通過思維鏈微調和強化學習實現高級推理能力 。

這一策略有助于模型建立在先前獲得的能力之上,從而在具身交互和自動駕駛領域實現穩健的性能。

階段1:具身智能監督微調 (Embodied AI Supervised Fine-tuning):結合通用數據和具身數據,建立核心的視覺語言理解、具身推理能力。

階段2:自動駕駛監督微調 (Autonomous Driving Supervised Fine-tuning): 在階段1的基礎上,加入大量自動駕駛數據。重點訓練多視角空間推理、視頻時間一致性和復雜交通場景分析 。

階段3:思維鏈推理微調 (CoT Supervised Fine-tuning): 使用包含明確推理步驟的數據進行微調。這增強了模型處理復雜多步問題的能力,例如風險評估和行為合理性解釋。

階段4:強化學習微調 (RL Fine-Tuning): 使用 GRPO (Group Relative Policy Optimization) 算法。通過針對正確性(如選擇題匹配、IoU計算)設計獎勵信號,進一步優化模型的精確度和可靠性。

實驗測試

為了驗證MiMo-Embodied的性能,研究分別在定性和定量兩層面進行評估,定量比較涉及針對具身智能和自動駕駛的各種既定學術和行業基準的客觀評估,從而能夠與領先模型進行直接的實證比較。

定性評估則展示了MiMo-Embodied在現實世界任務中的實際效能,突出了其在復雜機器人和自動駕駛場景中的部署,并提供了其將習得能力轉化為有效性能的具體證據 。

基準測試上的定量比較

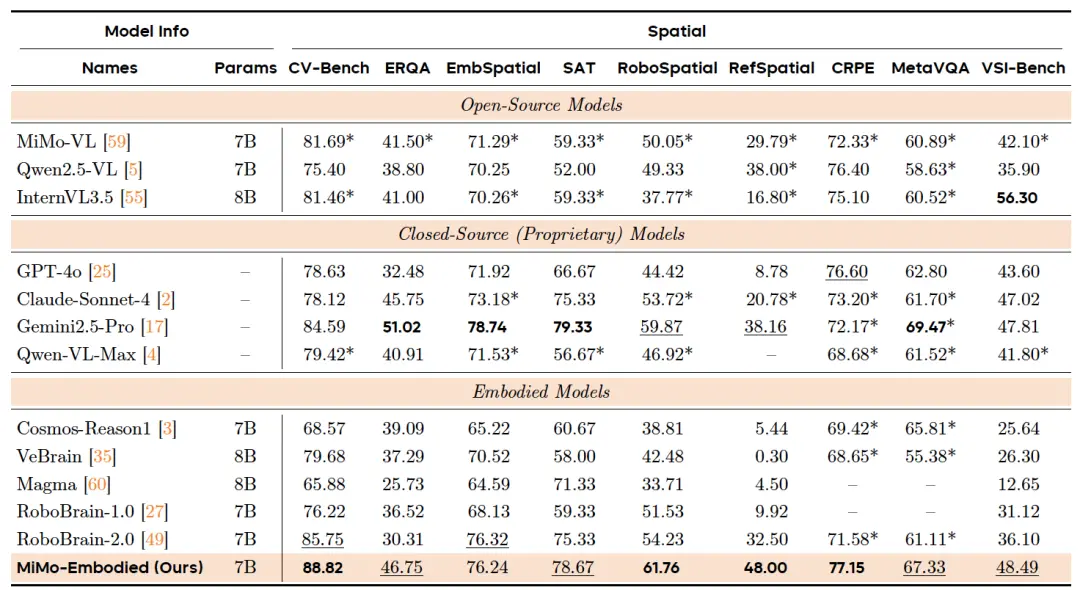

首先,在具身能力方面,研究在三個核心領域進行了全面評估:可供性預測、任務規劃和空間理解。

結果表明,MiMo-Embodied 取得了具有競爭力的結果,與通用多模態模型和專用具身模型相比,在可供性預測和空間理解方面表現出特別的優勢。

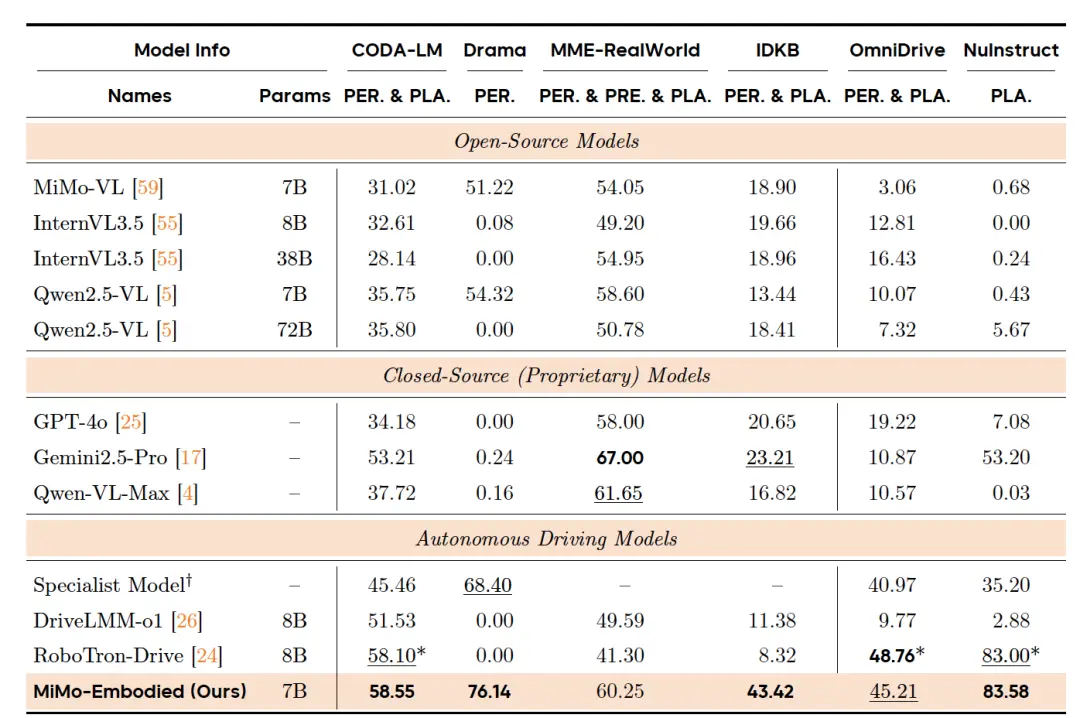

其次,在自動駕駛能力方面,研究在感知能力、預測能力和規劃能力上進行了評估。包含在4種數據類型上的12個基準測試中的性能,涉及其理解復雜交通場景、預測動態道路智能體行為以及生成安全高效駕駛建議的能力。

實驗結果顯示,MiMo-Embodied在所有感知基準測試、預測、規劃中均取得了強勁的性能,在全景語義理解任務中展示了最先進的結果,同時在具有挑戰性的局部感知場景中也表現出卓越的魯棒性。

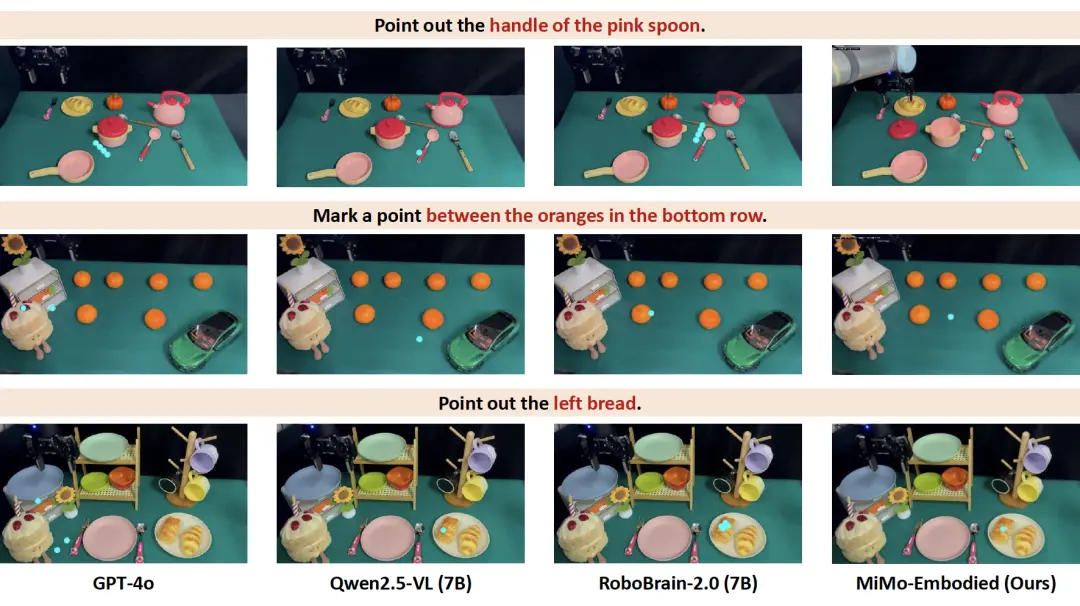

現實世界任務的定性評估

首先,為了驗證MiMo-Embodied 在復雜交互環境中的實際效用,研究評估了其在兩個基本下游應用中的性能:具身導航和操作。

在具身導航中,相較于GPT-4o、Qwen2.5-VL和RoboBrain-2.0,MiMo-Embodied展現出在多樣化家庭場景中增強的對象定位能力和一致的性能。

在操作任務中,MiMo-Embodied同樣展現出強大的可供性和空間推理能力。

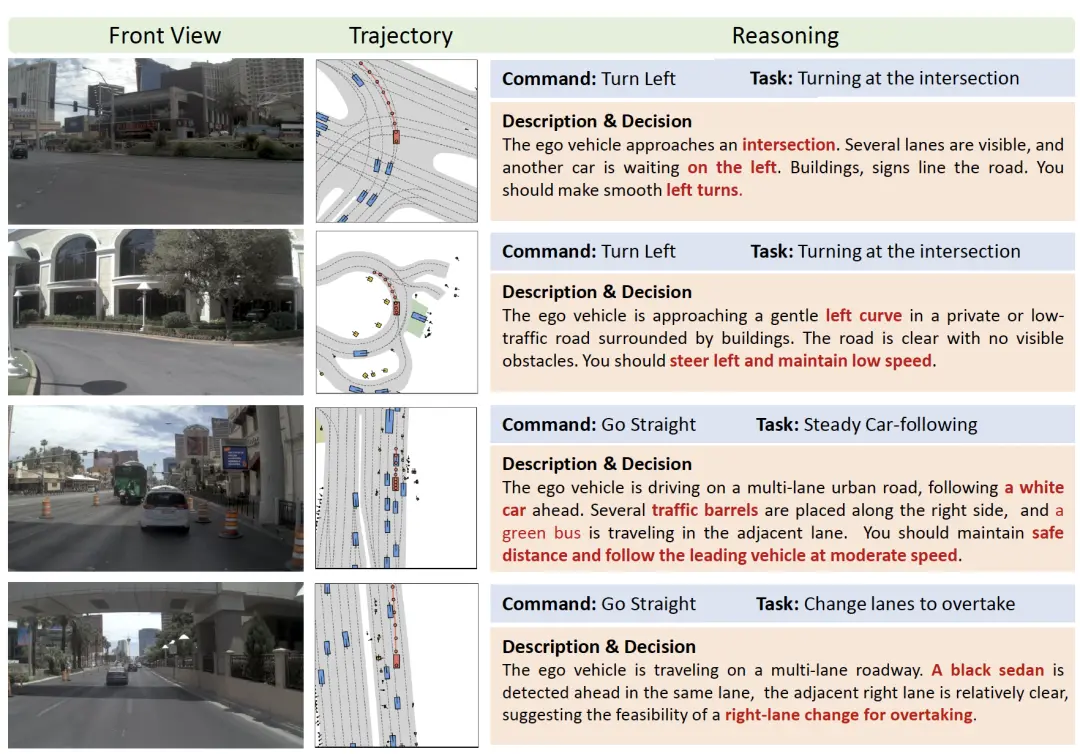

在自動駕駛能力上,研究首先在NAVSIM上確定性能以進行標準化比較,然后在一個包含多樣化真實世界駕駛場景的大規模專有數據集上測試模型的能力。

實驗結果表明MiMo-Embodied可以處理多樣化的自動駕駛情況并完成具有挑戰性的任務,包括交叉路口轉彎、彎道掉頭、跟車和變道超車。

在每種情況下,模型都應感知道路上下文,整合自車狀態和導航意圖,并做出連貫的決策。

此外,MiMo-Embodied在所有評估類別中始終優于基線。值得注意的是,在轉彎、繞開障礙物和變道等復雜、交互式操作中,性能提升最為顯著。

在最后,論文表示還將基于MiMo-Embodied模型的能力,探索具身智能視覺-語言-動作(VLA)模型,以增強復雜環境中的交互,通過自然語言理解實現更直觀的任務執行。

One more thing

這篇論文,是羅福莉于11月12日正式官宣加盟小米、出任MiMo團隊負責人后,發布的第一篇論文。

作為業界備受關注的95后AI才女,她本科畢業于北京師范大學,碩士在北京大學繼續深耕。

碩士畢業后,她加入阿里巴巴達摩院擔任機器智能實驗室研究員,主導開發多語言預訓練模型 VECO,并推動核心項目AliceMind的開源落地。

2022 年,羅福莉加入DeepSeek母公司幻方量化,后續任職DeepSeek深度學習研究員,深度參與 DeepSeek-V2等標桿模型的研發工作。

而本論文的Project Leader(項目負責人)陳龍,也于今年正式入職小米,擔任智能駕駛首席科學家。

在此之前,陳龍曾任職于英國AI獨角獸公司Wayve,主導新一代端到端自動駕駛VLA模型的研發。

更早前,他還以研究工程師身份加入Lyft,牽頭車隊學習項目,通過大規模眾包車隊數據完成自動駕駛車輛機器學習規劃器的預訓練。